Ce sunt duplicatele paginilor interne și cum să le gestionați

Autorul - Constantin Nacul

Adresele URL sunt diferite, dar conținutul paginii este același. Crezi că e în regulă? Doar câteva pagini identice de pe site. Dar același conținut poate fi filtrat de motoarele de căutare. Pentru a preveni acest lucru, trebuie să știți cum să scăpați de duplicatele paginilor interne.

Conceptul de pagini duplicate și tipurile acestora

Duble - acestea sunt pagini separate ale site-ului, al căror conținut coincide total sau parțial. În esență, acestea sunt copii ale întregii pagini sau ale unei anumite părți a acesteia, disponibile la adrese URL unice.

Ce duce la apariția duplicatelor pe site:

1. Generarea automată a paginilor duplicate de către motorul sistemului de management al conținutului (CMS) al resursei web. De exemplu:

https://site.net/press-centre/cat/view/identifier/novosti/

https://site.net/press-centre/novosti/

2. Greșeli făcute de webmasteri. De exemplu, când același produs este listat în mai multe categorii și disponibil la adrese URL diferite:

https://site.net/category-1/product-1/

https://site.net/category-2/product-1/

3. Schimbarea structurii site-ului, atunci când paginilor existente li se atribuie adrese noi, dar duplicatele acestora cu adresele vechi sunt păstrate. De exemplu:

https://site.net/catalog/product

https://site.net/catalog/category/product

Există două tipuri de luări: complete și parțiale.

Ce sunt duplicatele complete

Acestea sunt pagini cu conținut identic, disponibile la adrese unice, inegale. Exemple de luări complete:

1. Adresele URL ale paginilor cu și fără bare oblice ("/", "//", "///") la sfârșit:

https://site.net/catalog///product; https://site.net/catalog//////product.

2. Pagini HTTP și HTTPS: https//site.net; http://site.net.

3. Adrese cu „www” și fără „www”: http://www.site.net; http://site.net.

4. Adresele URL ale paginilor cu index.php, index.html, index.htm, default.asp, default.aspx, home:

https://site.net/index.html;

https://site.net/index.php;

https://site.net/home.

5. Adresele URL ale paginilor în majuscule și minuscule:

https://site.net/example/;

https://site.net/EXAMPLE/;

https://site.net/Example/.

6. Modificări în structura ierarhică a URL-ului. De exemplu, dacă un produs este disponibil la mai multe adrese URL diferite:

https://site.net/catalog/dir/tovar;

https://site.net/catalog/tovar;

https://site.net/tovar;

https://site.net/dir/tovar.

7. Parametri și etichete suplimentare în adresa URL.

- Adresa URL cu parametri GET: https://site.net/index.php?example=10&product=25. Pagina este pe deplin în concordanță cu următoarele: https://site.net/index.php?example=25&cat=10.

- Prezența etichetelor utm și a parametrilor gclid. Etichetele Utm ajută la furnizarea de informații sistemului de analiză pentru analiza și urmărirea diferiților parametri de trafic. Adresa URL a paginii de destinație la care sunt adăugate etichetele utm arată astfel: https://www.site.net/?utm_source=adsite&utm_campaign=adcampaign&utm_term=adkeyword

- opțiunile gclid (Google Click Identifier). Etichetă URL de destinație care este adăugată automat pentru a urmări datele despre companie, canal și cuvinte cheie în Google Analytics. De exemplu, dacă se face clic pe anunțul de pe site https://site.net, atunci adresa de redirecționare a vizitatorului va arăta astfel: https://site.net/?gclid=123xyz.

- etichetă yclid. Ajută la urmărirea eficacității campaniilor de publicitate în Yandex Metrica. Eticheta vă permite să urmăriți acțiunile unui vizitator care a mers pe site printr-o reclamă. Iată cum arată adresa de salt: https://site.net/?yclid=321.

- eticheta openstat. Universal și este, de asemenea, folosit pentru a analiza eficacitatea campaniilor de publicitate, a analiza traficul site-ului și comportamentul utilizatorilor pe site. Link etichetat „openstat”: https://site.net/?_openstat=231645789.

- Duble care sunt create printr-un link de recomandare. Un link de recomandare este un link special cu identificatorul dvs., prin care site-urile recunosc de la cine provine un nou vizitator. De exemplu: https://site.net/register/?refid=398992; https://site.net/index.php?cf=reg-newr&ref=Uncertainty.

8. Prima pagina a paginarii catalogului de produse a unui magazin online sau avizier, blog. Adesea corespunde unei pagini de categorie sau secțiuni generale: https://site.net/catalog; https://site.net/catalog/page1.

9. Setările incorecte de eroare 404 duc la mai multe duplicate. De exemplu: https://site.net/rococro-23489-rocoroc; https://site.net/8888-???.

Textul aldine poate conține orice caracter și/sau numere. Paginile de acest fel ar trebui să returneze un cod de răspuns al serverului 404 (nu 200) sau să redirecționeze către pagina reală.

Ce sunt preluari parțiale

În paginile parțial duplicate, conținutul este același, dar există mici diferențe în elemente.

Tipuri de preluari parțiale:

1. Duplicate pe cardurile de produse și paginile de categorii (catalog). Aici apar dubluri din cauza descrierilor de produse care sunt prezentate pe pagina generală a produsului din catalog. Și aceleași descrieri sunt prezentate pe paginile cardurilor de produse. De exemplu, în catalogul de pe pagina categoriei, sub fiecare produs există o descriere a acestui produs:

Și același text pe pagina produsului:

Pentru a evita dublarea, nu afișați informații complete despre produse pe pagina categoriei (catalog). Sau folosiți o descriere care nu se repetă.

2. Duplicate pe paginile de pagini de filtre, sortare, căutare și paginare, unde există conținut similar și se modifică doar ordinea de plasare. Cu toate acestea, textul descrierii și titlurile nu se modifică.

3. Duplicate pe pagini pentru imprimare sau pentru descărcare, ale căror date corespund în totalitate paginilor principale. De exemplu:

https://site.net/novosti/novost1

https://site.net/novosti/novost1/print

Dublatele parțiale sunt mai greu de observat. Dar consecințele acestora apar sistematic și afectează negativ clasamentul site-ului.

Ce cauzează pagini duplicate pe site

Duplicatele pot apărea indiferent de vârsta și numărul de pagini de pe site. Ele nu vor împiedica vizitatorul să obțină informațiile necesare. Situația este destul de diferită cu roboții motoarelor de căutare. Deoarece adresele URL sunt diferite, motoarele de căutare percep aceste pagini ca fiind diferite.

Consecința unei cantități mari de conținut duplicat este:

- Probleme de indexare. Când se generează pagini duplicate, dimensiunea totală a site-ului crește. Boții, indexând pagini „în plus”, cheltuiesc ineficient bugetul de crawling al proprietarului resursei web.

- Este posibil ca paginile „necesare” să nu intre deloc în index. Permiteți-mi să vă reamintesc că bugetul de accesare cu crawlere este numărul de pagini pe care botul le poate accesa cu crawlere într-o singură vizită pe site.

- Modificări ale paginii relevante din SERP. Algoritmul motorului de căutare poate decide că duplicatul este mai potrivit pentru interogare. Prin urmare, în rezultatele emiterii, va afișa pagina greșită, a cărei promovare era planificată. Un alt rezultat: din cauza competiției dintre paginile duplicate, niciuna dintre ele nu va intra în SERP.

- Pierderea greutății link-urilor paginilor care sunt promovate. Vizitatorii vor trimite către pagini duplicate, nu către pagini originale. Rezultatul este o pierdere a masei legăturii naturale.

Catalog de instrumente pentru găsirea paginilor duplicate

Așadar, am aflat deja ce sunt dublurile, ce sunt și la ce duc. Acum să trecem la cum să le găsim. Iată câteva modalități eficiente:

Căutați duplicate folosind programe speciale

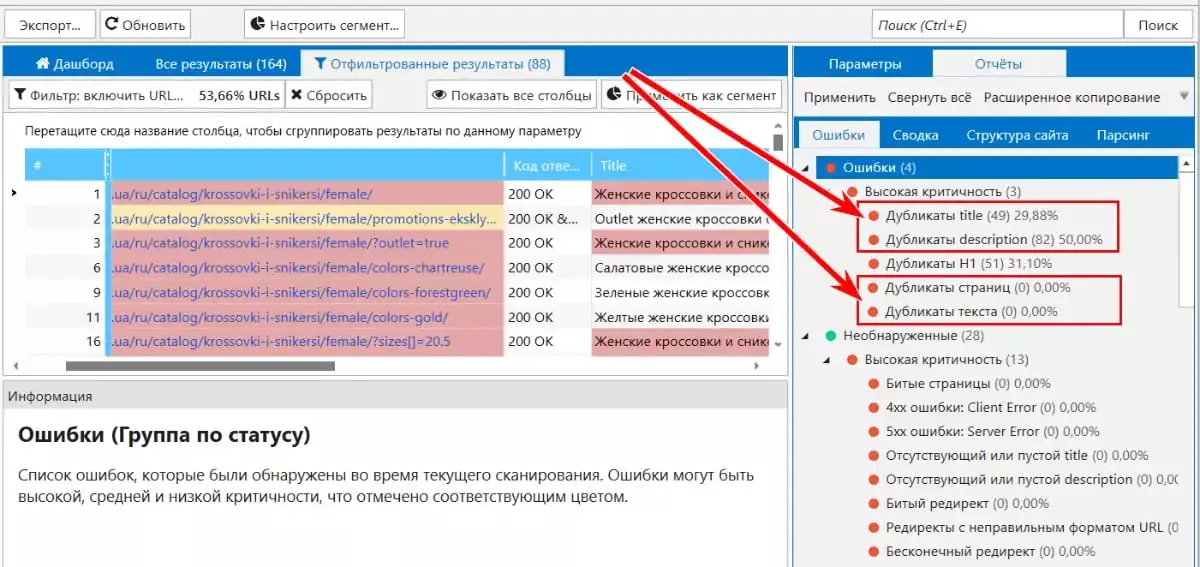

Păianjen Netpeak. Utilizând scanarea, puteți detecta pagini cu conținut duplicat: pagini duplicate complete, pagini duplicate după conținut bloc <body>, etichete repetate „Titlu” și metaetichete „Descriere”.

Utilizarea operatorilor de căutare

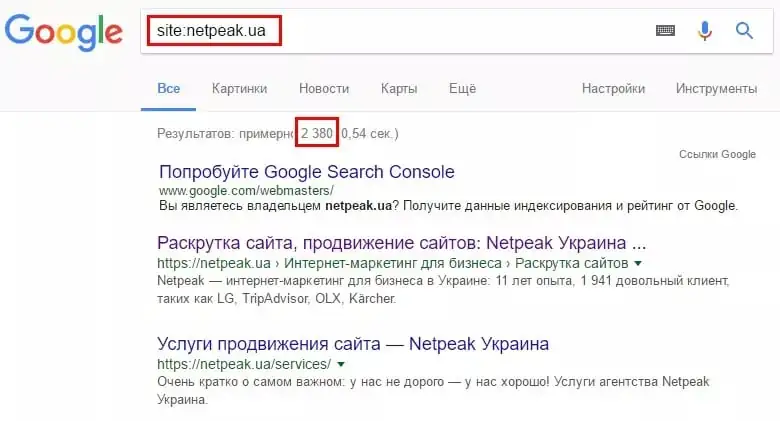

Pentru a căuta duplicate, puteți analiza paginile care sunt deja indexate folosind operatorul de căutare „site:”. Pentru a face acest lucru, în bara de căutare, de exemplu Google, introduceți interogarea „site:examplesite.net”. Va afișa paginile site-ului în indexul general. Astfel vom vedea numărul de pagini din rezultatele căutării, dacă este foarte diferit de numărul de pagini găsite de spider sau pagini din harta XML.

După examinarea rezultatelor, veți găsi pagini duplicat, precum și pagini „junk” care trebuie eliminate din index.

De asemenea, puteți utiliza căutarea pentru a analiza rezultatele căutării pentru o anumită bucată de text din pagini care, în opinia dvs., pot avea dubluri. Pentru a face acest lucru, luăm o parte din text între ghilimele, după care punem un spațiu, operatorul „site:” și o introducem în bara de căutare. Trebuie să specificați site-ul dvs. pentru a găsi pagini care conțin acest text special. De exemplu:

„Fragment de text dintr-o pagină de site care poate avea duplicate” site:examplesite.net

Dacă există o singură pagină în rezultatele căutării, atunci pagina nu are duplicate. Dacă există mai multe pagini în rezultatele căutării, este necesar să le analizați și să determinați motivele dublării textului. Poate că acestea sunt duplicate care trebuie eliminate.

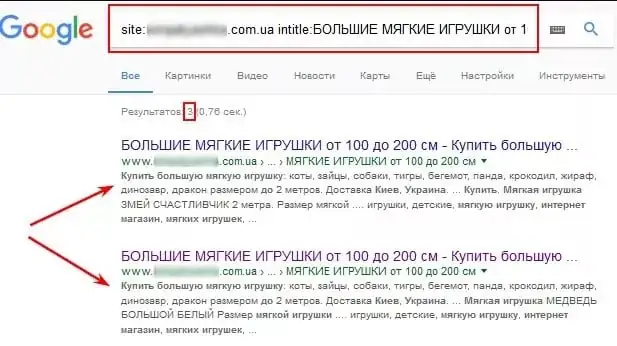

În mod similar, folosind operatorul „intitle:”, analizăm conținutul „Title” din paginile din ediție. „Titlul” duplicat este un semn al paginilor duplicate. Pentru a verifica, utilizați operatorul de căutare „site:”. În acest caz, introducem o interogare de forma:

site:examplesite.net intitle: textul integral sau parțial al etichetei Title.

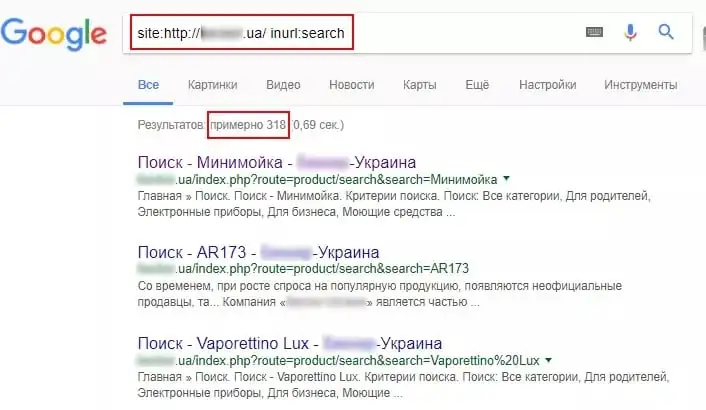

Folosind operatorii „site” și „inurl”, este posibil să se determine duplicatele paginilor care au apărut pe paginile de sortare (sortare) sau pe paginile de filtru și căutare (filtru, căutare).

De exemplu, pentru a căuta pagini de sortare în bara de căutare, trebuie să scrieți: site:examplesite.net inurl:sort.

Pentru a căuta filtrul și paginile de căutare: site:examplesite.net inurl:filter, search.

Rețineți, operatorii de căutare afișează doar duplicatele care au fost deja indexate. Prin urmare, nu vă puteți baza pe deplin pe această metodă.

Cum să scapi de duplicate

Am luat deja în considerare ce sunt duplicatele, tipurile, consecințele duplicaturilor și cum să le găsim. Acum să trecem la cel mai interesant lucru - cum să-i faceți să nu dăuneze optimizării. Folosim metode pentru a elimina paginile duplicate:

redirecționare 301

Este considerată metoda principală de eliminare a duplicatelor complete. O redirecționare 301 redirecționează automat de la o pagină a unui site web la alta. Conform redirecționării configurate, boții văd că pagina nu mai este disponibilă la această adresă URL și a fost mutată la o altă adresă.

O redirecționare 301 vă permite să treceți sucul de link de la o pagină duplicată către pagina principală.

Această metodă este relevantă pentru eliminarea dublelor care apar din cauza:

- URL în diferite registre;

- ierarhii URL;

- definițiile oglinzii site-ului principal;

- probleme cu barele oblice în URL-uri.

De exemplu, redirecționările 301 sunt folosite pentru a redirecționa din pagini:

- https://site.net/catalog///product;

- https://site.net/catalog//////product;

- https://site.net/product la https://site.net/catalog/product.

Fișierul Robots.txt

Folosind metoda, vă recomandăm să căutați în roboți care pagini sau fișiere nu trebuie accesate cu crawlere.

Pentru a face acest lucru, trebuie să utilizați directiva „Disallow”, care interzice roboților de căutare să acceseze pagini inutile.

Agent utilizator: *

Nu permite: /pagina

Rețineți că, dacă pagina este listată în robots.txt cu directiva Disallow, această pagină poate apărea în continuare în rezultatele căutării. De ce? A mai fost indexat sau are legături interne sau externe. Instrucțiunile Robots.txt sunt consultative pentru roboții de căutare. Ei nu pot garanta eliminarea duplicatelor.

Metaetichetă și

Metaetichetă îi spune robotului să nu indexeze documentul și să nu urmeze link-uri. Spre deosebire de robots.txt, această metaetichetă este o comandă directă și nu va fi ignorată de crawler-uri.

Metaetichetă instruiește robotul să nu indexeze documentul, dar în același timp să urmeze linkurile plasate în acesta.

Dar, potrivit purtătorului de cuvânt al Google, John Mueller, mai devreme sau mai târziu, metaeticheta „noindex, follow” este percepută de motorul de căutare ca „noindex, nofollow”.

Adică, dacă botul vizitează pentru prima dată și vede directiva „noindex, follow”, atunci nu indexează pagina, dar probabilitatea de a face clic pe link-urile interne rămâne în continuare. Dar dacă botul revine după un timp și vede din nou „noindex, follow”, atunci pagina este complet eliminată din index, botul încetează să o mai viziteze și să țină cont de linkurile plasate pe această pagină. Aceasta înseamnă că, pe termen lung, nu există nicio diferență între metaetichetele „noindex, follow” și „noindex, nofollow”.

Pentru a utiliza metoda, trebuie să plasați pagini duplicate într-un bloc una dintre metaetichete:

sau asemănător: ; .

atribut rel="canonic".

Utilizați metoda când pagina nu poate fi ștearsă și trebuie lăsată deschisă pentru vizualizare.

Etichetă pentru eliminarea duplicatelor de pe paginile de filtre și sortare, pagini cu get-parameters și utm-tags. Folosit pentru tipărire, atunci când se utilizează același conținut de informații în versiuni de limbi diferite și pe domenii diferite. Atributul rel="canonical" pentru diferite domenii nu este acceptat de toate motoarele de căutare. Pentru Google, va fi clar, Yandex îl va ignora.

Specificând un link canonic, indicăm adresa paginii care este preferată pentru indexare. De exemplu, site-ul are o categorie „Laptop-uri”. Conține filtre care arată diferite opțiuni de selecție. Și anume: marca, culoarea, rezoluția ecranului, materialul carcasei etc. Dacă aceste pagini de filtrare nu vor fi promovate, atunci specificăm pagina de categorie generală pentru ele ca fiind canonică.

Cum se setează pagina canonică? Plasați atributul rel="canonical" între etichete din codul HTML al paginii curente … .

De exemplu, pentru pagini:

- https://site.net/index.php?example=10&product=25;

- https://site.net/example?filtr1=%5b%25D0%,filtr2=%5b%25D0%259F%;

- https://site.net/example/print.

Pagina va fi canonică https://site.net/example.

În codul HTML va arăta astfel: .

Сoncluzii

1. Duplicatele sunt pagini separate ale site-ului, al căror conținut coincide total sau parțial.

2. Motivele apariției duplicatelor pe site: generare automată, greșeli făcute de webmasteri, modificări în structura site-ului.

3. La ce duc duplicatele de pe site: indexarea se înrăutățește; modificări în pagina relevantă din rezultatele căutării; pierderea masei naturale de linkuri de către paginile promovate.

4. Metode de căutare duplicate: utilizarea programelor parser (Netpeak Spider); site-ul operatorului de căutare.

5. Instrumente de eliminare a duplicărilor: comenzi corespunzătoare în fișierul robots.txt; meta name tag="roboți" content="noindex, nofollow"; etichetă rel="canonic"; redirecționare 301.

Ați eliminat conținutul duplicat? Acum trebuie să verificați din nou site-ul. Deci veți vedea eficacitatea acțiunilor întreprinse, evaluați eficacitatea metodei alese. Vă recomandăm să analizați site-ul în mod regulat pentru dubluri. Acesta este singurul mod de a identifica și elimina erorile în timp.

O sursă: Netpeak